Bei der Entwicklung von Entscheidungssysteme z.B. für eine Verkehrsflusssteuerung verfolgen Ingenieure meist einen von zwei Standardansätzen: Entweder implementieren sie ein KI-Modell für jede Kreuzung, das dann jeweils mit den individuellen Kreuzungsdaten trainiert wird. Oder sie nutzen ein großes Modell, das mit den Daten aller Kreuzung trainiert wurde und auf jede Kreuzung angewendet wird.

Die so realisierten Verstärkungslernmodelle versagen aber oft schon bei kleinen Abweichungen von den trainierten Aufgaben. Im Falle der Verkehrsflussregelung reichen Unterschiede zu den trainierten Situationen in Bezug auf die geltenden Geschwindigkeitsbegrenzungen, die vorhandene Fahrspuranzahl oder die Verkehrsmuster aus, um die Zuverlässigkeit des Modells zu beeinträchtigen.

Um die Zuverlässigkeit von Reinforcement-Learning-Modellen für komplexe Aufgaben mit Schwankungen zu erhöhen, haben Forscher des MIT nun einen anderen Ansatz untersucht und dafür den MBTL-Algorithmus (Model-Based Transfer Learning) entwickelt.

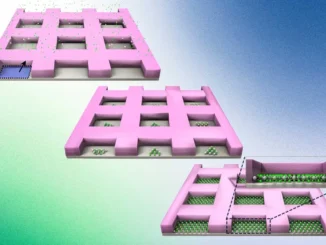

Der MBTL-Algorithmus besteht aus zwei Teilen. Erst wird modelliert, wie gut die einzelnen Algorithmen abschneiden würden, wenn sie unabhängig voneinander für eine Aufgabe trainiert würden. Dann wird modelliert, wie stark sich die Leistung jedes Algorithmus verschlechtern würde, wenn er auf jede andere Aufgabe übertragen würde. Durch die explizite Modellierung dieser Generalisierungsleistung kann MBTL den Wert des Trainings für eine neue Aufgabe abschätzen.

Durch die Konzentration auf eine kleinere Anzahl von Kreuzungen, die den größten Beitrag zur Gesamteffizienz des Algorithmus leisten, maximiert diese Methode die Leistung und hält gleichzeitig die Trainingskosten niedrig.

Die Forscher fanden heraus, dass ihre Methode bei einer Reihe von simulierten Aufgaben zwischen fünf und 50-mal effizienter war als die erwähnten Standardansätze. Dieser Effizienzgewinn hilft dem Algorithmus, schneller eine bessere Lösung zu erlernen, was letztlich die Leistung des KI-Agenten verbessert. (jr)