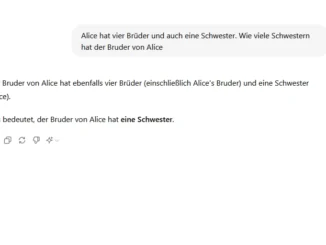

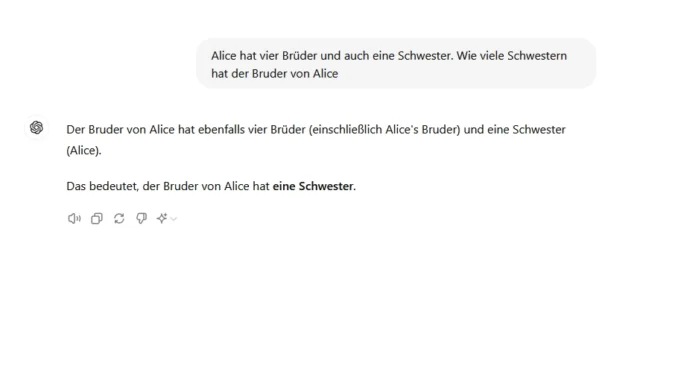

Selbst die besten KI-Sprachmodelle versagen bei logischen Fragestellungen dramatisch. Zu dieser Erkenntnis gelangen Forschende des Jülich Supercomputing Centre (JSC), der School of Electrical and Electronic Engineering der Universität Bristol und dem KI-Labor LAION. In ihrem Paper, „Alice in Wonderland: Simple Tasks Showing Complete Reasoning Breakdown in State-Of-the-Art Large Language Models“, attestieren die Forschenden den getesteten topmodernen LLM einen „starken Zusammenbruch der Funktions- und Denkfähigkeit“ und vermuten, dass Sprachmodelle zwar die grundlegende Fähigkeit haben, Schlussfolgerungen zu ziehen, diese aber nicht zuverlässig abrufen können. Sie fordern die wissenschaftliche und technologisch Gemeinschaft dazu auf, eine dringende Neubewertung der behaupteten Fähigkeiten der aktuellen Generation von LLM anzuregen. Darüber hinaus verlangen sie die Entwicklung standardisierter Benchmarks, um Schwächen von Sprachmodellen bezüglich ihrer Argumentationsfähigkeit aufzudecken – denn gängige Tests haben diesen gravierenden Fehler bisher offenbar nicht erkannt. (jr)