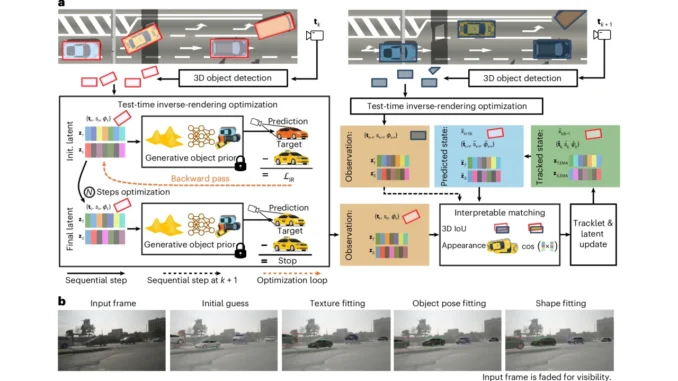

Forschende der Princeton University haben kürzlich einen neuen Ansatz für das inverse Rendering vorgestellt, der eine Extraktion von Szenenbeschreibung aus 2D-Bild- bzw. Video-Datensätzen erlaubt. Sie drehen damit den Prozess um, mit dem sonst mithilfe von generativer KI und neuronalem Rendering auf Basis von Szenenbeschreibungen neue Bilder bzw. Video künstlich erzeugt werden.

Das neue Verfahren nutzt generative KI-Modelle zur Simulation des Bilderzeugungsprozesses mit schrittweiser Anpassung der Modellparameter zur Optimierung. So kann es eine Vielzahl von Bildern zuverlässiger interpretieren, als bisher genutzte Ansätze.

Dabei wird die Bildverarbeitungsaufgaben wie beispielsweise das Objekt-Tracking als Optimierungsprobleme zur Testzeit gelöst. Im Gegensatz zu bestehenden überwachten Lernmethoden lässt sich das Verfahren auf andere Datensätze ohne erneutes Training übertragen. (jr)